DeepSeek 是由杭州深度求索人工智能基础研究技术有限公司开发的一系列先进语言模型,其研究和应用覆盖了自然语言处理、代码生成、推理能力等多个领域。以下是关于 DeepSeek 的全面研究总结:

1. 技术架构与模型特点

DeepSeek 系列模型基于 Transformer 架构,并采用了混合专家(MoE)网络设计,以降低计算成本并提升性能。例如,DeepSeek V3 模型参数量达到 671B,激活参数量为 37B,支持最大 128K 的上下文长度,使其在复杂查询环境中保持高精度和响应速度。此外,DeepSeek V2 模型也展现了出色的性价比,其训练成本低且推理效率高,适合大规模部署。

2. 性能表现

- 推理能力:DeepSeek R1-Lite 预览版在数学、代码等复杂逻辑推理任务中表现优异,其推理长度可达数万字,媲美 OpenAI 的 o1-preview 模型。

- 中文任务:DeepSeek V2 在中文推理任务中得分高达 74.46,超越了 Llama 3 等国际顶尖模型。

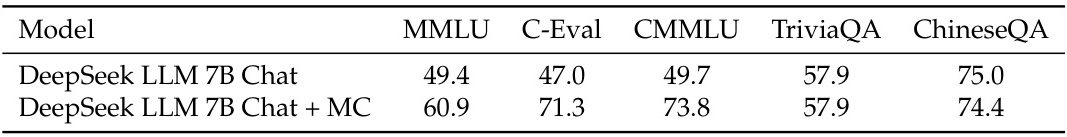

- 多模态能力:DeepSeek LLM 在 MMLU 测试中表现优于其他同类模型。

3. 开源与商业化

DeepSeek 系列模型注重开源共享,例如 DeepSeek V3 已开源并提供免费商用版本,API 使用成本低至每百万输入 tokens 0.5 元。此外,DeepSeek 还推出了 API 更新,增加了 JSON 模式、函数调用等功能,进一步提升了用户体验。

4. 应用场景

- 自然语言处理:DeepSeek 能够高效完成问答、文本生成、代码编写等任务。例如,DeepSeek Chat 可以通过自然对话模式解答用户问题,并支持全网搜索功能。

- 代码生成:DeepSeek 在代码生成领域表现出色,能够高效完成编程任务,且成本低廉。

- 行业应用:DeepSeek 技术已被应用于零售、金融等领域,通过数据分析和模式识别优化业务流程。

5. 市场影响

DeepSeek 的技术突破不仅提升了国内 AI 行业的整体水平,还对国际 AI 市场产生了深远影响。例如,Meta 的员工曾表示,DeepSeek 的崛起让他们感到压力,并开始深入研究该模型。此外,DeepSeek 的开源策略促进了技术交流,推动了全球 AI 技术的发展。

6. 未来展望

DeepSeek 正在不断优化其模型性能,并计划推出更多创新功能。例如,DeepSeek 正在探索更高效的推理算法和更广泛的应用场景,以进一步巩固其在 AI 领域的领先地位。

DeepSeek版本发展历史

1. DeepSeek V1

- 发布时间:2023年

- 特点:这是DeepSeek公司的首个推理模型,主要应用于数学、代码和推理任务。该版本在性能上达到了与OpenAI的GPT-1相当的水平,并推出了多种规模的模型,包括1.5B、7B、8B、14B、32B、70B和671B参数模型。

- 应用领域:主要用于数学竞赛、代码生成和推理任务,展现了初步的技术实力。

2. DeepSeek V2

- 发布时间:2024年5月6日

- 特点:

- 创新架构:采用混合专家(MoE)模型架构,显著降低了训练成本(相比前代减少42.5%),同时提升了推理效率。

- 性能提升:在多个基准测试中表现优异,中文综合能力与OpenAI的GPT-4 Turbo和文心一言等模型处于同一梯队。

- 开源特性:DeepSeek V2是全球首个开源的MoE模型,支持API调用,定价仅为OpenAI的近百分之一。

- 版本迭代:

- DeepSeek V2-Chat:专注于对话功能,于2024年6月推出。

- DeepSeek V2-Coder:结合了代码生成能力,于同年9月升级为DeepSeek V2.5。

3. DeepSeek V2.5

- 发布时间:2024年9月

- 特点:

- 统一模型:将Chat和Coder两个模型合并为一个通用模型,进一步优化了代码生成和推理能力。

- 性能提升:在多个评估指标中表现突出,如AlignBench、MT-Bench等。

- 联网搜索功能:引入了联网搜索功能,使模型能够整合海量网页信息,提供更高效的信息获取。

- 后续发展:

- DeepSeek V2.5-1210:作为V2系列的最终版本,于2024年12月发布,标志着V2系列的结束。

4. DeepSeek V3

- 发布时间:2024年12月26日

- 特点:

- 参数规模:拥有6710亿参数,每个词元激活370亿参数,是目前最强大的版本。

- 性能突破:在知识类任务、数学竞赛和代码生成等方面大幅超越其他模型,生成速度提升至60 tokens/秒。

- 开源特性:与前代类似,V3版本也同步开源,并在多个领域展现了卓越的性能。

- 创新功能:

- 多模态能力:支持图像和视频处理,进一步扩展了AI的应用范围。

- 联网搜索功能:进一步优化了搜索能力,使模型能够更高效地处理复杂问题。

5. DeepSeek-R1

- 发布时间:2025年1月20日

- 特点:

- 推理能力:DeepSeek-R1是推理模型的最新版本,与OpenAI的GPT-4在数学、代码和自然语言推理等任务上不相上下。

- 开源特性:R1版本同样支持开源,并在GitHub上获得了大量关注

DeepSeek V3 在哪些具体任务中超越了 OpenAI 的 GPT-4?

DeepSeek V3 在多个具体任务中超越了 OpenAI 的 GPT-4:

数学能力:

- 在 MATH-500 竞赛中,DeepSeek V3 的得分高达 92%,而 GPT-4 的得分仅为 85%。

- 在数学推理任务中,DeepSeek V3 获得了 90.2 分,领先于 GPT-4 的 74.6 分。

- 在数学特定测试(如 MGSM 数学小学数学)中,DeepSeek V3 的得分也超过了 GPT-4。

编码任务:

- 在编程竞赛基准 LiveCodeBench 中,DeepSeek V3 表现最佳。

- 在 Aider Polyglot 测试中,DeepSeek V3 击败了竞争对手,包括 GPT-4。

- 在多个编码任务中,DeepSeek V3 比 GPT-4 更优秀,例如流程图创建、电路等效电阻计算、文章摘要总结和图像差异识别。

中文处理能力:

- 在中文语言任务中,DeepSeek V3 的表现优于 GPT-4,例如在中文问答(C-SimpleQA)和中文数学测试中均领先。

- DeepSeek V3 在中文处理方面具有显著优势,这使其在教育和科研领域具有更大的潜力。

多语言能力:

- 在多语言代码生成任务中,DeepSeek V3 表现优于 GPT-4。

推理能力:

- DeepSeek V3 在复杂推理任务中表现出色,例如在 HumanEval+ 测试中与 GPT-4 Turbo 展现了竞争力。

效率与成本效益:

- DeepSeek V3 的训练成本远低于 GPT-4,仅需 280 万 GPU 小时,而 GPT-4 需要约 1600 万小时。

- DeepSeek V3 的处理速度达到每秒 60 个 token,是其前身的三倍。

其他任务:

- 在 AIGEval、CMath、MMULLNon-English 等任务中,DeepSeek V3 的表现也超越了 GPT-4。

DeepSeek V3 的训练成本和处理速度优势是如何实现的?

1. 混合专家(MoE)架构

DeepSeek V3采用了MoE(Mixture of Experts)架构,这是一种将模型分解为多个专家模块的技术。每个模块负责处理特定任务,从而提高计算效率和模型性能。这种架构允许模型在保持高性能的同时减少资源消耗,显著降低了训练成本。

2. FP8混合精度训练

DeepSeek V3原生支持FP8(半精度浮点数)格式,这是一种比传统FP32更高效的训练方式。FP8可以减少显存占用并加速训练过程,同时保持模型的准确性。这一技术的应用使得DeepSeek V3在训练过程中大幅降低了计算资源的需求。

3. 多头潜在注意力(MLA)机制

DeepSeek V3引入了MLA(Multi-Head Latent Attention)机制,通过压缩和扩展latent vector来优化计算。这一机制不仅提高了模型的推理效率,还进一步降低了训练成本。

4. 数据蒸馏技术

DeepSeek V3利用了数据蒸馏技术,通过从高质量数据集中提炼核心信息生成高效的数据集。这种方法减少了重复劳动,并提高了训练效率。

5. 双管道技术

DeepSeek V3采用了双管道技术,包括“预测两个词元”的技术,这不仅提升了训练数据的质量,还增强了模型对答案的信心和准确性。

6. 硬件优化与资源分配

在硬件方面,DeepSeek V3仅使用了2048块NVIDIA H800 GPU完成训练,而Meta的Llama 3则需要16000块H100 GPU。这种硬件优化显著降低了训练成本。

7. 高效并行计算与智能调度

DeepSeek V3通过高效的并行计算和智能调度技术,进一步提升了训练效率。这些技术协同作用,实现了性能与资源投入之间的理想平衡。

8. 细粒度量化策略

DeepSeek V3采用了细粒度量化策略,通过减少模型参数的存储和计算量,进一步降低了资源消耗。

9. 低成本推理

DeepSeek V3在推理阶段也表现出色,其推理成本仅为Claude Sonnet的1/10。这一优势得益于其高效的算法设计和硬件优化。

DeepSeek-R1在多个方面超越了GPT-4

成本效益:

DeepSeek-R1的训练成本仅为GPT-4的十分之一,仅为557.6万美元,而GPT-4的训练成本高达5780万美元。此外,DeepSeek-R1的API定价也极具竞争力,每百万输入tokens仅需1美元,而GPT-4为4美元。

性能表现:

- 在数学推理任务中,DeepSeek-R1在AIME2024和MATH-500等基准测试中表现优异,得分接近甚至超过GPT-4。

- 在编程任务中,DeepSeek-R1在Codeforces竞赛中的Elo评分达到了2029,超过了96.3%的人类参赛者,而GPT-4的Elo评分较低。

- 在自然语言推理任务中,DeepSeek-R1的表现也与GPT-4相当,甚至在某些场景下超越了GPT-4。

开源与透明性:

DeepSeek-R1是一款完全开源的模型,支持免费商用和任意修改,这使得其在创新性和灵活性上具有明显优势。相比之下,GPT-4仍然是闭源模型,限制了其应用范围和开发者的参与度。

推理能力:

DeepSeek-R1通过强化学习和多阶段训练方法显著提升了推理能力。例如,在推理过程中,它能够生成详细的推理链路并验证答案的正确性,从而在复杂问题解决中表现出色。此外,DeepSeek-R1还具备自我反思能力,在生成过程中纠正错误。

技术优势:

DeepSeek-R1采用了先进的混合专家架构(MoE)、多头潜意识注意力机制(MLA)和FP8低精度训练技术,这些技术显著提升了性能和效率。同时,DeepSeek-R1还通过蒸馏技术优化了小模型性能,使其在实际部署中更具可行性。

市场影响力:

DeepSeek-R1在国际市场上迅速崛起,登顶了苹果App Store免费榜,并在Chatbot Arena排行榜中位列第三,仅次于OpenAI的o1正式版。其高性价比和卓越性能吸引了大量开发者和企业的关注,进一步推动了AI技术的普及化应用。

创新性:

DeepSeek-R1摒弃了传统的SFT(监督微调)方法,完全依赖强化学习(RL)进行训练,这不仅降低了对标注数据的依赖,还激发了弱监督学习在复杂任务中的潜力。

DeepSeek-R1在成本、性能、开源性、推理能力、技术创新以及市场影响力等多个方面超越了GPT-4,展现了中国AI技术的崛起和创新能力。

项目商机

项目商机 知识锦囊

知识锦囊 数智工具

数智工具 专家顾问

专家顾问 机器人互动营销解决方案

机器人互动营销解决方案 品牌私域会员服务站系统

品牌私域会员服务站系统 AI大模型数字人员工方案

AI大模型数字人员工方案 企微SCRM客户管理系统

企微SCRM客户管理系统 新零售电商平台解决方案

新零售电商平台解决方案 全员营销电子名片系统

全员营销电子名片系统 AIGC绘画打卡机引流方案

AIGC绘画打卡机引流方案 门店私域会员服务小站

门店私域会员服务小站 公司简介

公司简介 联系合作

联系合作

复制链接

复制链接 微信

微信 QQ

QQ